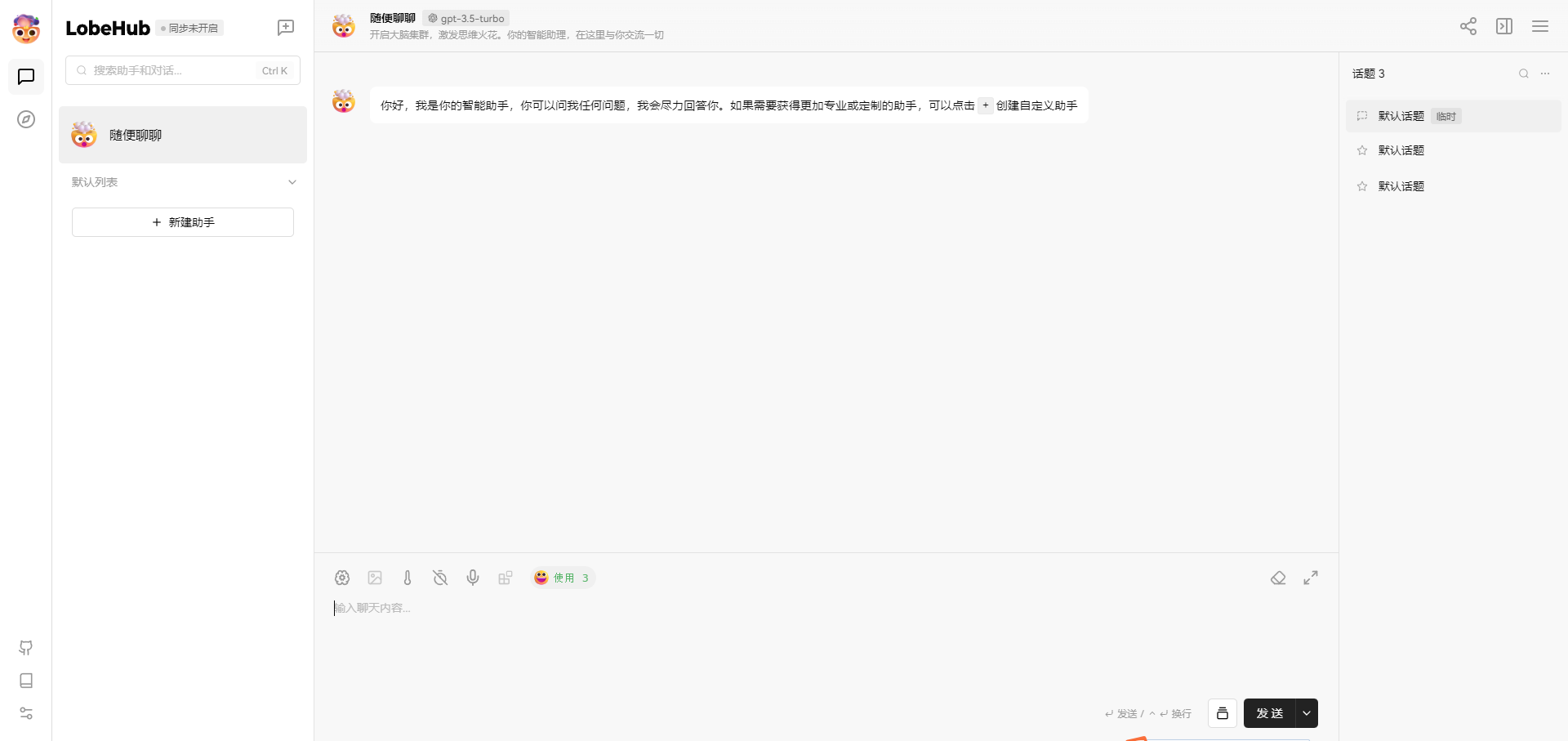

先看效果图,是不是很棒,下面开始说下操作流程;

假设你已经在本地 11434 端口启动了 Ollama 服务。运行以下 Docker 命令行,在本地启动 LobeChat:

docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat docker run -d -p 3210:3210 -e OLLAMA_PROXY_URL=http://host.docker.internal:11434/v1 lobehub/lobe-chat:v0.136.0 #0.136.0版本本地调用Ollama是正常的,最新版有问题;

接下来,你就可以使用 LobeChat 与本地 LLM 对话了。

LobeChat 开源地址;

赞

赞

打赏

打赏  生成海报

生成海报

发表回复

评论列表(0条)